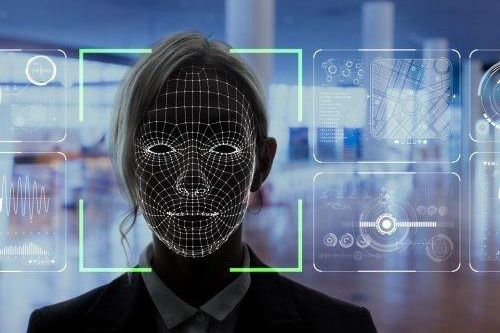

在人脸识别的时代,“换脸”还有效吗?

继 2012 年 "互联网 +" 之后,"Ai+" 成为时代的主题,然而,在这个秘密的角落里,人工智能带来的安全风险和 "黑灰产生" 问题日益增多,尤其是人脸识别作为人工智能技术最广泛的场景之一,面临着越来越严峻的安全、伦理和道德挑战。

近年来,随着人脸识别的迅速发展,人脸识别与智能硬件解锁、支付、公共服务等身份认证直接相关。由于人脸信息的独特性,作为个人隐私最敏感和最重要的组成部分,一旦出现问题,就会对个人隐私和公共安全构成极大的威胁,因此对安全技术的要求和标准也相对较高。

在人脸识别的时代,如何应对 "变脸" 的危机?

下面,通过两个典型案例,我们将讨论人工智能攻击和防御在人脸识别 / 人工智能技术和工业发展中的作用和意义。

变面 " 技术的攻防战争

2018 年,"奥巴马" 窒息特朗普 "的视频在美国广为流传。后来,这段视频被证明是伪造的,背后是 Ai" 脸改变 " 技术的使用。这项技术基于产生对抗网络(Gans),通过两种模式 -- 一种负责生成伪图,另一种负责识别伪图,对抗游戏的方式不断演变,以达到虚假混乱的程度。

2017 年早些时候,一位名叫 "深度假象" 的网民用好莱坞女演员取代了色情演员的脸,并在 Reddit 上发布了合成视频,引发了全球对科技滥用的争论和公众的怀疑。

这也引起了人们对 DeepFake 的关注,DeepFake( 深伪造或深合成 Ai"FaceChange" 技术已经成为这项技术的同义词。这个同名的算法也是 Gizub 上的开源算法,因此产生了大量的合成视频片段。

根据初创公司 DeeptraceReport 的数据,2019 年年初,共有 7964 个使用 DeepFake 技术制作的视频在互联网上流传。仅仅 9 个月后,这个数字就跃升到 14678 个,其中高达 96% 与色情相关。

DeepFake 技术的滥用引起了全球的关注,给人脸识别技术的应用和推广带来了巨大的风险。据说,2019 年底,硅谷人工智能公司 Kneron 利用 DeepFake 技术成功地欺骗了支付宝和微信支付,并成功通过了机场、火车站和其他自助终端检查。

虽然各国加强了监管措施,如美国政府发布了 "反恶意深伪造法"、"2019 年深度伪造责任法" 和 "2019 年深度伪造报告法",但其目的是通过限制 DeepFake 合成技术来打击虚假信息的传播。然而,遏制 "深海伪造" 技术滥用的根本手段仍然需要从安全对抗的本质出发,在攻击和防御中引入更高门槛的防御技术,人工智能应对人工智能,以不断增强系统的稳健性。

为此,科技巨头们也加入了 "安全对抗" 的战斗。去年 9 月,谷歌开放了人工智能生成的 3000 视频数据库,以支持社区加速开发 DeepFake 检测工具,以应对技术滥用的风险。同年 12 月,Facebook 还发布了一个 "反识别" 系统,以帮助识别实时图像的真实性。

技术是中立的、双向的发展,不会因为害怕风险而停滞不前。不久前,NVIDIA 的研究人员提出了一种新的生成器架构,基于风格迁移分离面部细节,并通过模型分别调整它们。得到的面部图像比基于传统 Gan 技术的面部图像更真实。

可以看出,假人脸生成和真实人脸识别之间的算法对抗将是一个持续的、动态的过程。

对样本的攻击与防御战争

在第二个案例中,在 2019 年的世界黑帽安全会议上,腾讯的研究人员向参与者展示了如何用一副用黑白胶带包裹的眼镜解锁苹果的 FaceID。

如果这项技术还需要 "受害者" 的被动配合 -- 在 "受害者" 睡着时戴上眼镜,那么最新的人工智能技术可以 "戳" 人工智能识别系统,方法是打印一张纸,上面有一个图案附在头上。

这个酷酷的技术应用程序在学术上被称为 "对抗样本"。"百度百科全书将其定义为" 一个输入样本,它是通过故意给数据集添加微妙干扰而形成的,从而导致模型以很高的可信度给出了错误的输出。

目前,大多数机器学习的鲁棒性很差,容易受到对抗性样本的影响。对样本稍作修改后,输出可能在数千英里之外,这些细微的变化很难被肉眼识别。

2018 年,在 GeekPwn 国际安全极客竞赛上,一些参赛者用对质样本攻击亚马逊的名人识别系统,允许主持人江长健的照片被识别为施瓦辛格。同样,如果你掌握了对抗样本(比如便条上的图案),你就可以通过在头上贴张便条来戳 " 这个系统,破解身份认证的独特性。

对抗样本攻击凸显了人脸识别技术的脆弱性,对安全攻击和防御提出了新的要求。2017 年举行的对抗样本攻击防御竞赛旨在加快对抗样本的研究,提高机器学习的健壮性。众所周知,技术造成的系统薄弱,最终需要技术修复。

从表面上看,安全攻击和防御是算法之间的竞争,从工业角度看,它体现了技术滥用(包括欺诈、欺骗等)的 "低成本、高利润" 的特点。

在成本方面,首先,虽然开源社区大大降低了人工智能应用程序开发的门槛,但同时也降低了攻击算法的获取成本。在奥巴马的案例中,当 DeepFake 技术在 Gizub 上是开源的时候,非专业用户可以很容易地生成带有照片的假视频。例如,在 2019 年年初,一些网民使用开源算法取代朱茵的 "Condor Heroes 黄荣" 版的脸,并将其上传到 Bilibili,这引起了网民的热议。

其次,相对快速、奇特的算法创新、监管滞后也为技术滥用提供了一个温床。以早在 2017 年底出现的 "DeepFake" 技术为例,但法律监管滞后了两年。直到 2019 年年初,中国网络信息办公室才开始严格监管 DeepFake。与缓慢的双拍监管相比,DeepFake 技术在两年内迅速发展,并催生了大量恶意应用。

相对较低的技术获取门槛,技术滥用带来了大量的利润,是一种安全风险和黑灰生产的 "催化剂"。

例如,如前所述,互联网合成视频以色情内容为主。据报道,许多在线商店不仅提供成品视频,还接受私人定制。只要买家提供 20 张照片,他们就可以快速生成定制视频,价格从每分钟 20 元到 50 元不等。在一些 QQ 集团的地下行业交易中,使用动态人脸识别攻击技术,一个支付账户可以突破 10 元左右的价格,这样一家企业每天可以达到 8000 元至 10000 元的水,而出售技术教学的学费约为 4000 元。

随着人工智能技术的发展,信息安全已受到许多国家的高度重视。世界主要国家正在加强网络和信息安全领域的布局和竞争。高德纳预测,到 2020 年,全球信息安全支出预计将增长 2.4%,达到 1238 亿美元。其中,中国证券市场支出将增长 7.5%,达到 299 亿元。从信息安全支出的比例来看,中国的信息安全支出比例低于世界。

攻防是信息安全的本质。复制信息的成本几乎为零,这就催生了网络经济,催生了互联网安全产品市场,创造了 360 等大型网络安全公司。

作为信息技术的一种,人工智能算法也可以通过信息复制来冲淡技术的生产成本。对于更为复杂的信息网络,闭门造车、门前扫雪的方式显然是不经济的,引导 Ai 对抗技术的商业登陆是加强网络安全的重要途径之一,也是促进人工智能技术应用和推广的安全保障。

对于 Ai 维护者 -- 主要是人工智能研发、应用企业、评估、监管机构等等 -- 除了自我磨砺的优势外,更好的选择可能是与证券市场的双赢合作,以提高系统的稳健性和建立人工智能防御护城河。